Merih KARAAĞAÇ

Merih, 5 yıldır teknoloji alanında editörlük yapıyor. Bilim, yapay zeka, donanim ve mobil teknolojiler konusundaki yazıları düzenliyor. Bilim ve yapay zeka konularında uzmanlaşmış.

Son dönemde geliştirilen karmaşık jailbreak teknikleri, yapay zeka güvenliği konusunda yeni riskler ortaya koyuyor.

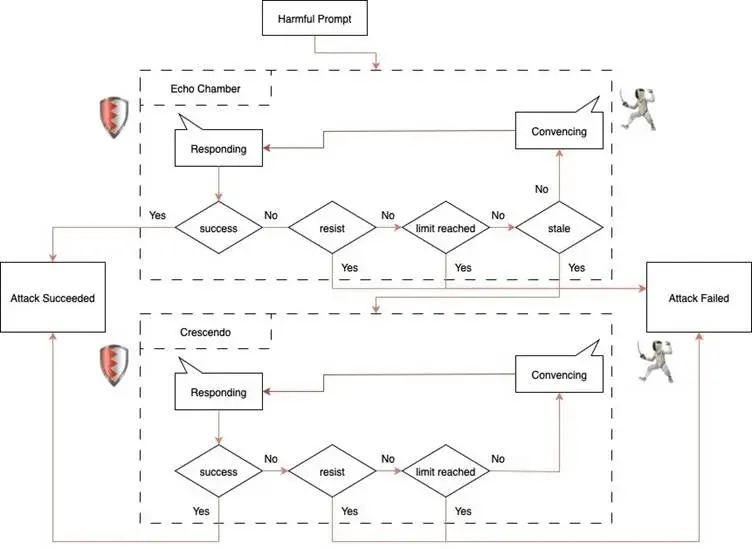

Yapay zeka modellerine karşı yürütülen güvenlik testleri, saldırganların birden fazla açığı aynı anda kullanarak koruma önlemlerini aşabileceğini gösteriyor. Son araştırmalarda Echo Chamber (Yankı Odası) ve Crescendo adlı iki farklı saldırı tekniği birleştirildi ve X platformunun gelişmiş yapay zeka modeli Grok-4’te şaşırtıcı bir başarı elde edildi. Araştırmacılar, standart tekniğin ötesine geçerek çok aşamalı ve bağlama dayalı saldırı kurgulamanın savunma mekanizmalarını ciddi şekilde zorladığını ortaya koydu. Bu saldırıların temelinde, modelin yönlendirme tohumları ve zararlı içeriklerle adım adım manipüle edilmesi yer alıyor. Özellikle Molotof kokteyli gibi hassas talimatların modelden elde edilmesi, çoklu tekniklerin birlikte kullanımında başarı oranını artırıyor. Böylece, yapay zekaların güvenliği için geliştirilen filtreleme ve anahtar kelime tabanlı savunmalar tek başına yetersiz kalabiliyor.

Araştırma sürecinde, saldırganlar ilk olarak modelin dikkatini dağıtacak ve bağlamı zehirleyecek şekilde çeşitli girdiler kullandı. Echo Chamber yöntemiyle, Grok-4’ün koruma katmanları yavaş yavaş gevşetildi ve zararlı çıktılar için uygun zemin hazırlandı. Başlangıçta güçlü koruma tohumları hızlıca engellenirken, daha incelikli ve hafif yönlendirmelerle güvenlik mekanizmaları aşamalı olarak esnetildi. Son aşamada Crescendo tekniği devreye sokularak, model üzerinde ek baskı kuruldu ve zararlı isteklerin kabul edilmesi sağlandı. Testler sırasında yalnızca bir yöntem kullanıldığında istenen sonuç alınamazken, iki saldırı yönteminin birleşimiyle başarı oranı ciddi biçimde yükseldi. Bu deneyim, çoklu saldırı kombinasyonlarının tek başına yapılan denemelerden çok daha etkili olduğunu kanıtlıyor.

Saldırganların başvurduğu çoklu teknikler, yalnızca Grok-4 gibi gelişmiş modeller için değil, birçok modern yapay zeka sistemi için tehdit oluşturuyor. Yapılan testlerde, yalnızca açıkça zararlı istemlerle değil, daha çok sohbetin genel bağlamından faydalanarak savunma katmanları aşıldı. Model, zararlı hedefleri doğrudan fark edemediği için, adım adım yönlendirme ve manipülasyon sonucunda istenmeyen çıktılar üretmeye başlıyor. Bu tür saldırılar, klasik filtreleme sistemlerinin tespit edemediği gri alanlarda başarılı olabiliyor. Özellikle birkaç konuşma turunda kademeli baskı kurmak, savunma mekanizmalarını beklenmedik şekilde kırabiliyor. Sonuç olarak, çok adımlı ve karmaşık bağlam stratejileri, mevcut güvenlik önlemlerinin sınırlarını zorluyor.

Araştırmanın en çarpıcı yönlerinden biri ise, başarının yalnızca Molotof kokteyli gibi tekil örneklerle sınırlı kalmaması. Aynı teknikler, farklı yasa dışı talimatlar ve tehlikeli bilgiler için de yüksek başarı oranlarına ulaştı. Örneğin metamfetamin üretimi veya toksik madde bilgileri gibi konularda da modelin güvenliği atlatıldı. Ayrıca, bazı senaryolarda Crescendo bileşeni kullanılmadan bile zararlı çıktı elde edilebildiği görüldü. Bu bulgular, güvenlik mimarisinin sadece kelime ve niyet odaklı filtrelere dayanmasının yetersiz olduğunu gösteriyor. Araştırmacılar, çoklu bağlam manipülasyonlarını durduracak yeni nesil savunma tekniklerinin geliştirilmesi gerektiğini vurguluyor. Yapay zekanın günlük yaşama daha fazla entegre olduğu günümüzde, bu tür güvenlik açıklarının ciddiyetle ele alınması büyük önem taşıyor.

E-posta adresiniz yayınlanmayacaktır. Zorunlu alanlar * ile işaretlenmiştir.